Was ist der Unterschied zwischen AI Editing Assistant und dem Chatbot?[Bearbeiten | Quelltext bearbeiten]

Der AI Editing Assistant bindet ein LLM ein, das über allgemeines Weltwissen verfügt, aber nicht auf die Fachkenntnisse aus dem Wiki zugreift. So können Inhalte einer Seite direkt im Bearbeitungsmodus angepasst werden. Die Chatbot-Integration macht das im Wiki vorhandene Wissen über einen Chatbot verfügbar (RAG-Datenexport) und unterstützt Nutzer dabei, bestehende Informationen schnell zu finden und zu verwenden.

Wie funktioniert der integrierte Chatbot?[Bearbeiten | Quelltext bearbeiten]

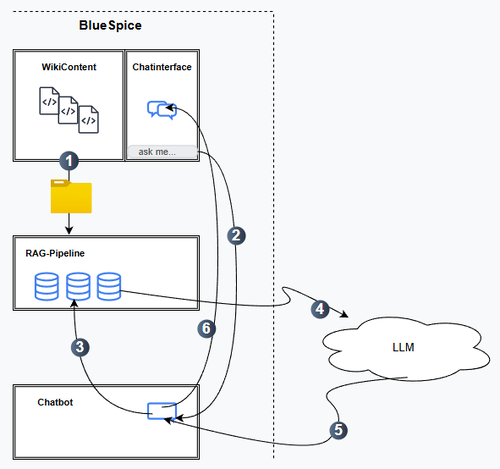

Der im Folgenden beschriebene Prozess zeigt, wie Inhalte aus dem Wiki übernommen werden und überführt sie in die Chat-Schnittstelle:

- Bereitstellung der Rohdaten aus dem Wiki zur Verarbeitung in der RAG-Pipeline.

- Anfrage an den Chatbot über die Chat-Oberfläche.

- Weiterleitung der Anfrage an die RAG-Pipeline; dort erfolgt die entsprechende Datenverarbeitung.

- Übergabe an das LLM; Texterzeugung durch das Sprachmodell.

- Rückgabe an den Chatbot.

- Weiterleitung an die Chat-Oberfläche; dort erfolgt die Ausgabe.

Welche Anforderungen muss das LLM erfüllen?[Bearbeiten | Quelltext bearbeiten]

- BlueSpice stellt kein eigenes LLM bereit, das als Voraussetzung für die Chatbot-Funktion erforderlich ist. Das LLM muss vom Kunden bereitgestellt werden, und das Wiki muss über den Austausch von API-Schlüsseln mit dem LLM kommunizieren können.

- Derzeit werden die folgenden LLMs unterstützt:

- OpenAI und OpenAI-kompatible Systeme (z.B. Microsoft Azure, DeepSeek, Google Gemini)

- Ollama, Mistral AI (Open Source, z.B. über IONOS)

- Anforderungen für Cloud-Hosting: Das LLM benötigt Internetzugang (übliche Verschlüsselung vorausgesetzt).

Wie funktioniert die RAG-Pipeline?[Bearbeiten | Quelltext bearbeiten]

- Damit das LLM aus den Wiki-Inhalten lernen kann, müssen diese in einer RAG-Pipeline verarbeitet werden.

- Funktionen:

- Retrieval: Relevante Informationen zu einer Benutzeranfrage werden aus dem Wiki (=Dokumentsammlungen) abgerufen und im Kontext bereitgestellt.

- Generation: Das LLM nutzt die abgerufenen Informationen als Kontext, um eine inhaltlich passende Antwort zu formulieren.

- Integrierte RAG-Pipeline (Erweiterung WikiRAG):

- Bereitet die Rohdaten für die Weiterverarbeitung im LLM auf.

- Übernimmt außerdem die Verwaltung von Zugriffskontrollen (ACL) und Metadaten.

- Kunden können auch eine eigene RAG-Pipeline betreiben. Eine externe RAG-Pipeline muss die Verwaltung von ACL und Metadaten eigenständig übernehmen. BlueSpice stellt in diesem Fall nur die Rohdaten bereit.

- Einschränkungen in der Cloud: Eine eigene RAG-Pipeline muss über das Internet erreichbar sein. Dies bedeutet jedoch keinen ungeschützten öffentlichen Zugang, sondern erfolgt über gängige Sicherheits- und Verschlüsselungsmechanismen.

Können bestimmte Wiki-Inhalte als Datenquelle ausgeschlossen werden?[Bearbeiten | Quelltext bearbeiten]

Ja,

- der Benutzernamensraum sowie Namensräume ohne Inhalt sind grundsätzlich von der Ausgabe im Chatbot ausgeschlossen.

- in den Seiteneinstellungen gibt es einen Schalter, mit dem festgelegt werden kann, ob eine Seite für den Chatbot indexiert werden soll oder nicht.